逃亡生活(ボート)part7

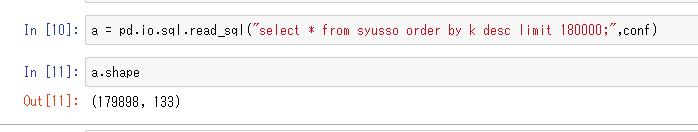

ようやくだらだら取得していたレコードが18万を超え、

そろそろビッグデータの扱いについて考えないといけない。

いちばん大事なのって実用性だと思う、

ということで一回.read_sqlで全部取得してみてどれくらいかかるか見てみる。

2分ぐらいで終わるわ、すごいすごいpandas。

なんか102件ぬけてますけど?

まあいいやこれで。

とりあえずこれで一回ガチでどの程度予想できるかやってみるか。

使う特徴量を選別→ndarrayに前処理して追加していく

最初はラベルのoheからやる、わかりやすいから。

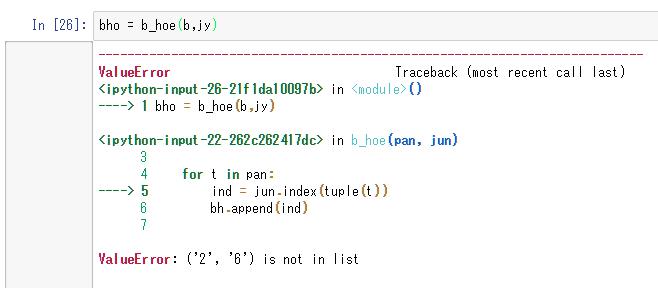

1着2着しかないデータがあるっぽいのでそのレコードを除外する。

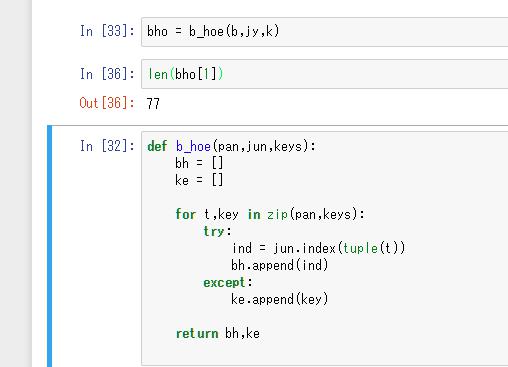

正規表現で除外するのが多分一般的かと思うがめんどくさいのでできなかったIDを返す関数にしよう。

77個あった

これをインデックスでドロップしていく

ac.drop(de, axis=0)

単にこれでよかった、払い戻し金とかぶったらとか考えてしまったが多分文字列だったはず。

年齢は前回やっているので、次は体重。

ターゲットと年齢体重まで入ったので

ここで一旦blogを閉じる

次回

場のデータ

ボートレース場データ | BOAT RACE オフィシャルウェブサイト

ここに過去3ヶ月間の枠ごとの勝率があるのでぶち込む